Google Cloud ha anunciado la disponibilidad del nuevo Operador Ray en GKE, lo que simplifica el proceso de escalado de cargas de trabajo Ray en entornos de producción. Esta integración proporciona a las organizaciones una forma eficiente de distribuir tareas entre múltiples máquinas, especialmente a medida que los modelos de IA generativa continúan creciendo en tamaño y alcance.

Un aspecto que me llamó especialmente la atención es la facilidad de uso que ofrece el Operador Ray. Al habilitar las API declarativas, los usuarios ahora pueden administrar clústeres Ray en GKE utilizando una única opción de configuración. Esto elimina la complejidad del proceso de configuración, lo que permite a los desarrolladores centrarse en crear e implementar sus aplicaciones de IA/ML.

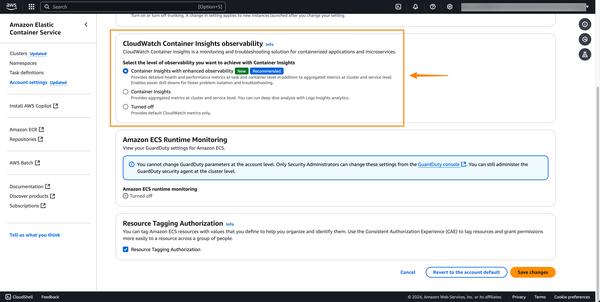

Además, el nuevo complemento admite funciones como el registro y la supervisión, lo que proporciona a los usuarios información valiosa sobre el rendimiento de sus aplicaciones. La integración de Cloud Logging y Cloud Monitoring facilita la identificación de cuellos de botella y errores de recursos, lo que garantiza el buen funcionamiento de las cargas de trabajo de Ray.

Por último, la adición de compatibilidad con TPU es una adición bienvenida. Al aprovechar la arquitectura AI Hypercomputer de Google, los usuarios ahora pueden aprovechar la potencia de las TPU para acelerar las tareas de entrenamiento e inferencia. Esta característica será particularmente beneficiosa para las organizaciones que trabajan con modelos grandes y requieren tiempos de procesamiento rápidos.

En general, el nuevo Operador Ray en GKE representa un importante paso adelante para que la computación distribuida sea más accesible. Al simplificar la administración de clústeres, mejorar la supervisión de recursos y admitir aceleradores de hardware especializados, Google Cloud permite a las organizaciones liberar todo el potencial de Ray para IA/ML en producción.