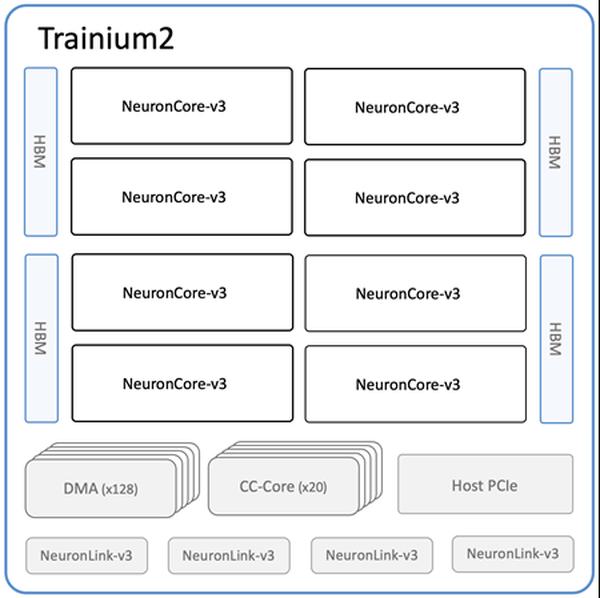

Amazon ha anunciado la disponibilidad de las nuevas instancias Amazon EC2 Trn2 y los Trn2 UltraServers, sus opciones de cómputo EC2 más potentes para el entrenamiento e inferencia de aprendizaje automático (ML). Impulsadas por la segunda generación de chips AWS Trainium (AWS Trainium2), las instancias Trn2 son 4 veces más rápidas, tienen 4 veces más ancho de banda de memoria y 3 veces más capacidad de memoria que las instancias Trn1 de primera generación. Ofrecen un rendimiento de precio entre un 30% y un 40% mejor que las instancias EC2 P5e y P5en basadas en GPU de la generación actual. Cada instancia Trn2 cuenta con 16 chips Trainium2, 192 vCPU, 2 TiB de memoria y 3,2 Tbps de ancho de banda de red del adaptador de tejido elástico (EFA) v3 con una latencia hasta un 50% menor. Los Trn2 UltraServers, una nueva oferta, cuentan con 64 chips Trainium2 conectados con una interconexión NeuronLink de alta ancho de banda y baja latencia, para un rendimiento máximo en modelos de base de vanguardia. Decenas de miles de chips Trainium ya impulsan los servicios de Amazon y AWS. Más de 80 000 chips AWS Inferentia y Trainium1 admitieron al asistente de compras Rufus en el Prime Day. Los chips Trainium2 impulsan las versiones optimizadas para latencia de los modelos Llama 3.1 405B y Claude 3.5 Haiku en Amazon Bedrock. Las instancias Trn2 están disponibles en la región Este de EE. UU. (Ohio) y se pueden reservar mediante los bloques de capacidad de Amazon EC2 para ML. Los desarrolladores pueden usar AMI de aprendizaje profundo de AWS, preconfiguradas con marcos como PyTorch y JAX. Las aplicaciones existentes del SDK de AWS Neuron se pueden recompilar para Trn2. El SDK se integra con JAX, PyTorch y bibliotecas como Hugging Face, PyTorch Lightning y NeMo. Neuron incluye optimizaciones para el entrenamiento e inferencia distribuidos con NxD Training y NxD Inference, y admite OpenXLA, lo que permite a los desarrolladores de PyTorch/XLA y JAX aprovechar las optimizaciones del compilador de Neuron.

Instancias Amazon EC2 Trn2 y Trn2 UltraServers ya disponibles para entrenamiento e inferencia de IA/ML

AWS