Amazon Web Services (AWS) anunció las comprobaciones de razonamiento automatizado (vista previa), una nueva protección en Amazon Bedrock Guardrails para ayudar a reducir las alucinaciones en los modelos de lenguaje grandes (LLM) al validar matemáticamente la precisión de sus respuestas. Esto aprovecha el razonamiento automatizado, un campo de la informática que utiliza pruebas matemáticas y deducción lógica para verificar el comportamiento de los sistemas y programas. A diferencia del aprendizaje automático (ML), que hace predicciones, el razonamiento automatizado proporciona garantías matemáticas sobre el comportamiento de un sistema. AWS ya utiliza el razonamiento automatizado en áreas de servicio clave como almacenamiento, redes, virtualización, identidad y criptografía. Por ejemplo, el razonamiento automatizado se utiliza para verificar formalmente la corrección de las implementaciones criptográficas, mejorando tanto el rendimiento como la velocidad de desarrollo. Ahora, AWS está aplicando un enfoque similar a la IA generativa. Las nuevas comprobaciones de razonamiento automatizado (vista previa) en Amazon Bedrock Guardrails son la primera protección de IA generativa que ayuda a prevenir errores fácticos de las alucinaciones utilizando un razonamiento lógicamente preciso y verificable que explica por qué las respuestas de la IA generativa son correctas. Las comprobaciones de razonamiento automatizado son particularmente útiles para casos de uso donde la precisión fáctica y la explicabilidad son importantes. Por ejemplo, podría utilizar las comprobaciones de razonamiento automatizado para validar las respuestas generadas por LLM sobre las políticas de recursos humanos (RRHH), la información del producto de la empresa o los flujos de trabajo operativos. Utilizadas junto con otras técnicas como la ingeniería rápida, la generación aumentada por recuperación (RAG) y las comprobaciones de conexión a tierra contextual, las comprobaciones de razonamiento automatizado añaden un enfoque más riguroso y verificable para garantizar que la salida generada por LLM sea fácticamente precisa. Al codificar su conocimiento de dominio en políticas estructuradas, puede garantizar que sus aplicaciones de IA conversacional proporcionen información fiable y digna de confianza a sus usuarios.

Evite errores fácticos de las alucinaciones de LLM con comprobaciones de razonamiento automatizado matemáticamente sólidas (vista previa)

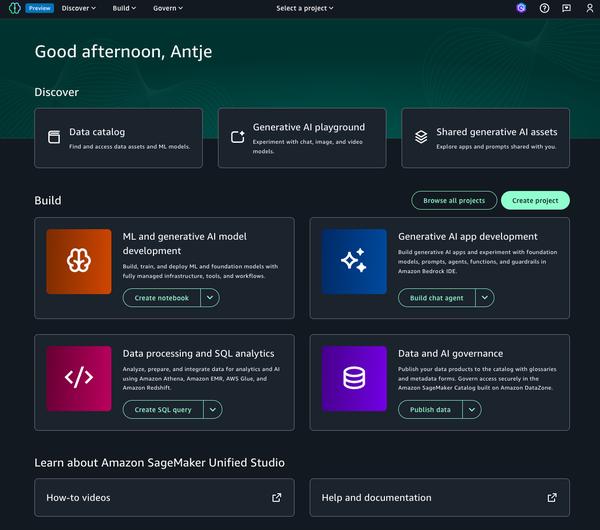

AWS