Google Cloud ha lanzado una demostración de una solución de búsqueda multimodal que permite buscar en imágenes y vídeos utilizando consultas de texto. Esta solución utiliza modelos de incrustación multimodal para comprender el contenido semántico de las imágenes y los vídeos, lo que permite realizar búsquedas más precisas y completas.

Esta demostración me entusiasma especialmente por su potencial en diversos ámbitos. Por ejemplo, imagina poder buscar en una amplia base de datos de imágenes médicas utilizando descripciones textuales de síntomas o anomalías. Esto podría permitir a los profesionales médicos realizar diagnósticos más rápidos y precisos.

Además, esta solución podría revolucionar la forma en que interactuamos con el contenido en línea. En lugar de depender únicamente de palabras clave, podríamos buscar utilizando una combinación de texto, imágenes y vídeos, lo que haría que las búsquedas fueran más intuitivas y fáciles de usar.

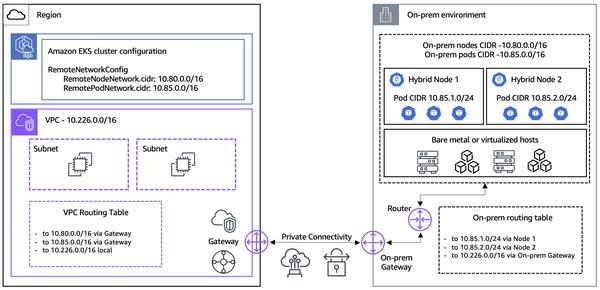

Sin embargo, hay algunos retos que deben abordarse antes de que la búsqueda multimodal pueda generalizarse. Uno de ellos es la necesidad de modelos de incrustación robustos que puedan comprender las complejidades semánticas de las distintas modalidades. Otro reto es la necesidad de una infraestructura escalable que pueda gestionar las enormes cantidades de datos que requieren las búsquedas multimodales.

En general, creo que la búsqueda multimodal tiene el potencial de revolucionar la forma en que buscamos y consumimos información. Estoy deseando ver cómo evoluciona esta tecnología en los próximos años.